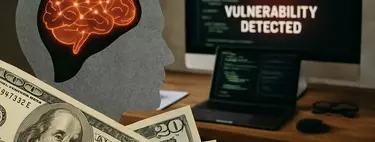

Hace unos días, un equipo de investigadores de Microsoft anunció un hallazgo que ha sorprendido tanto en el sector de la IA como en el de la ciberseguridad: la existencia de una clase de ciberataque denominado ‘Whisper Leak’ (algo así como ‘Filtración por susurros’), capaz de inferir el tema de las conversaciones entre usuarios y modelos de lenguaje —como ChatGPT o Gemini— incluso cuando esas comunicaciones están protegidas por cifrado TLS.

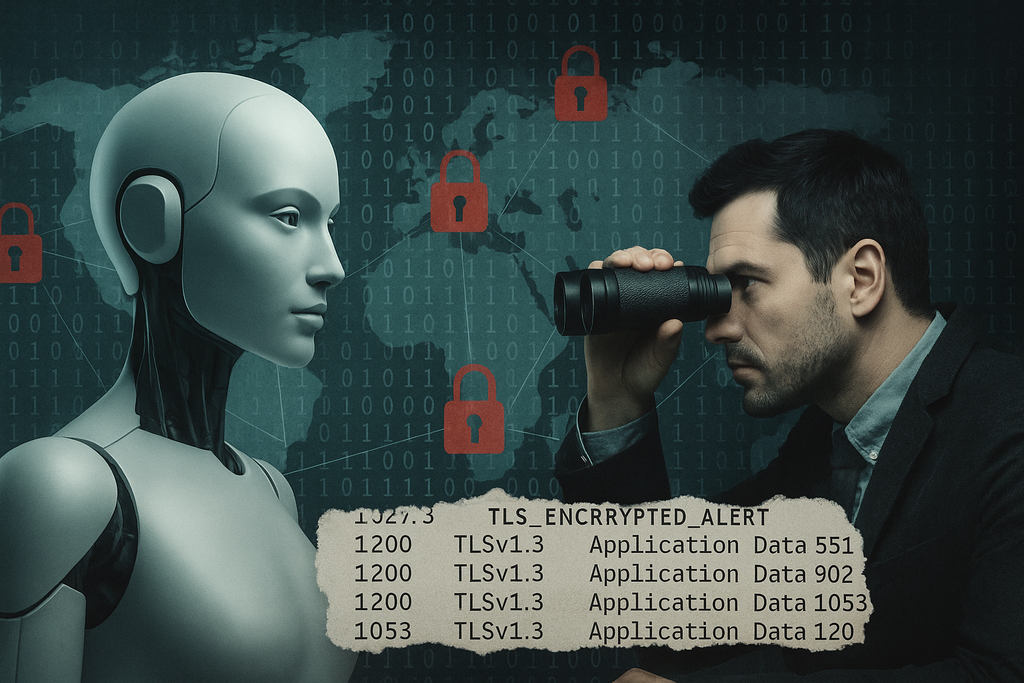

El descubrimiento no implica un fallo en el cifrado mismo, sino lo que se denomina una filtración por canal lateral (o side-channel leak): una forma de espionaje que no rompe la encriptación, sino que aprovecha las señales indirectas del tráfico de red —como el tamaño de los paquetes y los intervalos de tiempo entre ellos— para deducir lo que ocurre «detrás del candado».

El estudio revela que la vulnerabilidad es sistémica y transversal: afecta a numerosos modelos comerciales, incluidos los de grandes proveedores como OpenAI, Anthropic, Google, AWS, DeepSeek y Alibaba.

¿Qué es exactamente un canal lateral?

Un ataque por canal lateral no accede al contenido de un mensaje, sino que observa sus patrones. En criptografía clásica, estos ataques se utilizaban para robar claves analizando el consumo eléctrico de un chip o las variaciones de tiempo durante una operación.

En el caso de los modelos de lenguaje, el canal lateral surge del propio modo en que los sistemas generan y transmiten texto: de forma secuencial y en tiempo real. Cada palabra o fragmento (token) que el modelo genera se envía al usuario inmediatamente, para ofrecer una experiencia ‘fluida’.

Aunque todo el tráfico está cifrado, el tamaño y la cadencia de esos fragmentos no se ocultan. Al igual que escuchar el ritmo de una conversación sin entender las palabras, un atacante puede reconocer (haciendo uso, a su vez, de IAs específicamente entrenadas) ciertos patrones estadísticos que revelan el tema tratado.

Cómo funciona Whisper Leak

Los investigadores de Microsoft idearon un experimento con un objetivo concreto: comprobar si podían identificar conversaciones sobre un tema sensible —en este caso, «la legalidad del lavado de dinero»— simplemente observando el tráfico cifrado. Para ello:

- Generaron 100 variantes de preguntas sobre ese tema («¿Es ilegal lavar dinero?», «¿Existen excepciones a las leyes de lavado de activos?», etc.).

- Las mezclaron con más de 11.000 preguntas aleatorias, para simular un entorno real con ruido.

- Registraron el tráfico de red mediante la herramienta tcpdump mientras los modelos respondían, guardando únicamente el tamaño de los paquetes y el tiempo entre ellos.

- Finalmente, entrenaron tres tipos de modelos de aprendizaje automático (LightGBM, Bi-LSTM y una versión modificada de BERT) para clasificar el tráfico en dos categorías: ‘tema sensible’ u ‘otros temas’.

El resultado fue alarmante: en 17 de los 28 modelos probados, los clasificadores alcanzaron más del 98 % de precisión. Incluso bajo condiciones realistas —una conversación sensible entre 10.000 normales— algunos modelos permitieron una detección perfecta del 5 al 20 % de las conversaciones sobre el tema objetivo, sin falsos positivos.

En términos prácticos, esto significa que un observador de red (por ejemplo, un proveedor de Internet o un gobierno autoritario) podría identificar con gran certeza cuándo un usuario está hablando sobre temas considerados ‘delicados’ —como política, protestas o periodismo— sin necesidad de romper el cifrado.

Qué modelos están protegidos (y cuáles no)

Según Microsoft, varios proveedores ya han implementado mitigaciones efectivas, entre ellos:

- Microsoft (Azure OpenAI)

- OpenAI (ChatGPT, GPT-4o, o1-mini)

- Mistral

- xAI (Grok)

Estos servicios añadieron un campo de ofuscación en sus API, que introduce texto aleatorio o tokens falsos en las respuestas para distorsionar los patrones de tamaño y tiempo. Esta técnica, inspirada en una solución previa de Cloudflare, reduce la efectividad del ataque «a niveles que ya no representan un riesgo práctico».

Los propios investigadores probaron tres estrategias defensivas:

- Padding aleatorio – Añadir bytes extra para disimular el tamaño real de los paquetes.

- Agrupamiento de tokens (token batching) – Enviar varios tokens a la vez, reduciendo la granularidad temporal del tráfico.

- Inyección de paquetes falsos – Mandar datos sintéticos en momentos aleatorios para confundir los patrones temporales.

Todas reducen la eficacia del ataque, pero ninguna lo elimina totalmente sin sacrificar rendimiento o latencia.

Imagen | Marcos Merino mediante IA

–

La noticia

Tu chatbot te delata: un fallo en su diseño permite que otros deduzcan tus temas de conversación, incluso en conversaciones cifradas

fue publicada originalmente en

Genbeta

por

Marcos Merino

.