Vale que Apple sigue sin ser la reina de la IA generativa por mucho que quiera y que ni siquiera ha llegado aún la nueva Siri. Sin embargo, ha mejorado recientemente su modelo de análisis de imágenes, Visual Intelligence. Lo hace de la mano de iOS 26 y es de lo más interesante.

Eso sí, te recordamos que esta es una función limitada a modelos compatibles con Apple Intelligence. Es decir, que aparte de iOS 26, deberás tener un iPhone 15 Pro o cualquier otro modelo posterior.

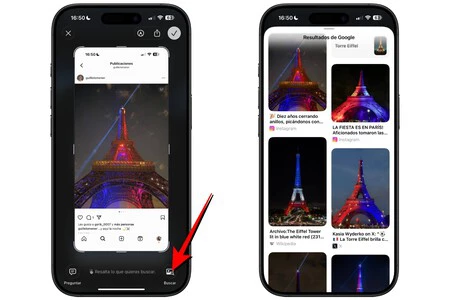

Visual Intelligence detecta ahora tus capturas

Si es la primera vez que lees algo sobre Visual Intelligence, conocida también como Inteligencia Visual en castellano, debes saber que es algo así como el Google Lens de Apple. De hecho, utiliza tecnología de la propia Google, además de ChatGPT. Se trata de una herramienta que permite usar la cámara para obtener información del entorno.

Saber de qué tipo es una planta, traducir un letrero escrito en otro idioma o entender los iconos de las prendas para saber cómo lavarlas correctamente son solo algunos de los muchos ejemplos.

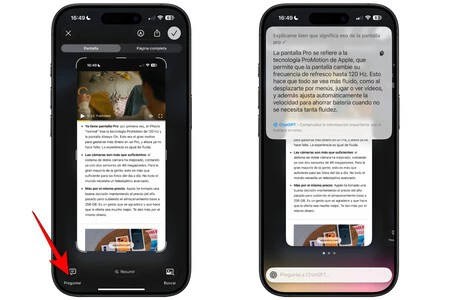

Todo esto llegó ya con anteriores versiones (en español está disponible desde iOS 18.4). Lo nuevo que añade es que ahora también reconoce capturas de pantalla. Quizás puedas pensar que no es tan útil como con la cámara, pero puede que lo sea igual e incluso más.

Función de preguntar

Poder analizar elementos de una foto es de lo más útil para, por ejemplo, identificar rápidamente un producto que viste en una app y buscarlo en internet sin tener que describirlo manualmente. También extraer un número de teléfono o dirección de una captura y usarlo directamente se hace mucho más sencillo con esta funcionalidad.

Para acceder a esta herramienta hay varias opciones:

|

funciones de cámara |

funciones de captura |

|

|---|---|---|

|

iPhone 15 Pro |

Configurándolo en el botón de acción desde Ajustes > Botón de acción > Inteligencia Visual. |

Haciendo una captura y pulsando en la opción Preguntar o Buscar imágenes. |

|

iPhone 16 |

Manteniendo pulsado el botón de control de cámara y/o configurándolo en el botón de acción desde Ajustes > Botón de acción > Inteligencia Visual. |

Haciendo una captura y pulsando en la opción Preguntar o Buscar imágenes. |

Esta detección de elementos de la captura mezcla tecnología de Google y OpenAI. Es la primera la que es capaz de identificar las imágenes cuando le damos a la opción de búsqueda de imágenes. En la opción de preguntar es ChatGPT el que actúa.

Función de buscar imágenes

En ejemplos de uso de esta última nos encontramos con pedirle un resumen automático de una receta que has guardado en una captura o que te explique los pasos clave de un tutorial sin tener que leer todo el texto de la captura. Un caso real para el que yo mismo lo usé fue usar el mapa del Metro de Barcelona y pedirle que me dijese la mejor ruta desde un punto de la ciudad a otro.

Si bien no son funciones que al final no pudiésemos tener directamente en las apps de Google o ChatGPT, tenerlas integradas las hace mucho más cómodas. De hecho, no es ni siquiera necesario tener ninguna de ellas en el iPhone.

En Applesfera | Apple Intelligence: guía completa de funciones y cómo aprovecharlas al máximo

En Applesfera | Nuevo iOS 27 – todo lo que creemos saber sobre el futuro sistema operativo para el iPhone

–

La noticia

La IA de Apple ha mejorado con iOS 26. Así puede ayudarte lo nuevo de Visual Intelligence

fue publicada originalmente en

Applesfera

por

Álvaro García M.

.