El pasado 7 de agosto, OpenAI lanzaba su nuevo modelo de lenguaje GPT-5 y, en un intento de simplificar su oferta, retiró de inmediato todos los modelos anteriores de la interfaz de ChatGPT sin previo aviso. La medida provoca una de las mayores protestas de usuarios que se recuerdan en la plataforma, incluidos hilos multitudinarios en Reddit criticando tanto la calidad del nuevo modelo como lo forzoso del cambio.

Sin embargo, tras una semana turbulenta, Sam Altman ha anunciado que GPT-4o vuelve a ChatGPT tras admitir que la empresa subestimó cuánto valoraban los usuarios determinados rasgos del modelo.

Así, OpenAI ha restituido la disponibilidad de GPT-4o para quienes pagan por ChatGPT (Plus, Pro, Team, Enterprise y Edu), y Altman se ha comprometido, además, a avisar con suficiente antelación si en el futuro se retirase de nuevo.

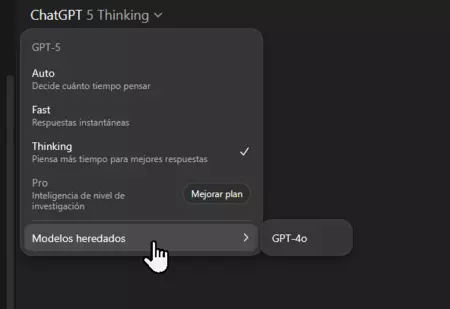

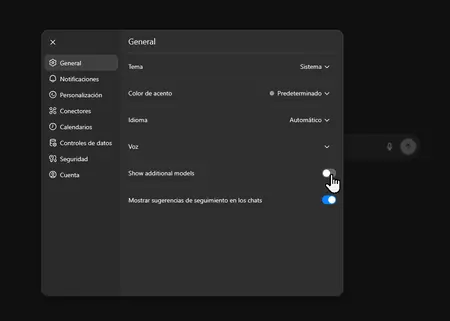

La decisión llega, además, acompañada de nuevos controles para GPT-5 («Auto», «Fast» y «Thinking»), límites de uso revisados para el modo «Thinking» y la posibilidad de activar «Mostrar modelos adicionales» en la configuración de usuario, opción que nos devuelve el acceso también a otras variantes como GPT-4.1, o3 y o4-min (GPT-4.5 seguirá siendo exclusivo de Pro debido a su alto coste de cómputo en GPU).

Por qué todos estos cambios

- Coste de simplificar en exceso. La retirada súbita de modelos populares ha causado todo tipo de problemas a los usuarios, acostumbrados a un comportamiento y un tipo de respuestas concretas de las que dependían sus flujos de trabajo.

Altman ha reconocido que infravaloraron rasgos específicos de GPT-4o que los usuarios en realidad apreciaban, desde su «personalidad» hasta sus reacciones en tareas concretas.

- Calidad percibida y fallos operativos. La recepción de GPT-5 fue mixta: inconstancias frente a 4o y problemas de infraestructura (como el ‘autoselector’ fallido) dieron alas a la frustración de los usuarios.

Los tres modos de uso en GPT-5

Para quienes opten por GPT-5, la interfaz permite ahora elegir explícitamente el modo de respuesta:

- Fast (Como su nombre indica, ofrece resultados muy rápidamente, pero lo hace a costa de la profundidas y verificación de su respuesta).

- Thinking (Respuestas con más razonamiento y pasos intermedios, lo que mejora la calidad de las mismas a expensas de su rapidez.

- Auto (Selección automática de uno de los dos modos anteriores, según el caso).

La idea tras estos cambios pasa por devolver control al usuario, a la vista de que el autoenrutador usados durante los primeros días de GPT-5 redirigía mal las peticiones, en la opinión de muchos usuarios.

Límites y ventana de contexto del modo ‘Thinking’

El modo Thinking de GPT-5 ofrece una ventana de 196.000 tokens y pasa a tener un límite de 3.000 mensajes por semana para suscriptores de pago. Al alcanzar el tope, se puede seguir usando GPT-5 Thinking mini como alternativa ligera. OpenAI deja la puerta abierta a ajustar estos límites según el uso real.

Imagen | Marcos Merino mediante IA

–

La noticia

La rebelión de los usuarios de ChatGPT triunfa, y podremos volver a usar modelos antiguos como GPT-4o. GPT-5 no ha convencido a todos

fue publicada originalmente en

Genbeta

por

Marcos Merino

.