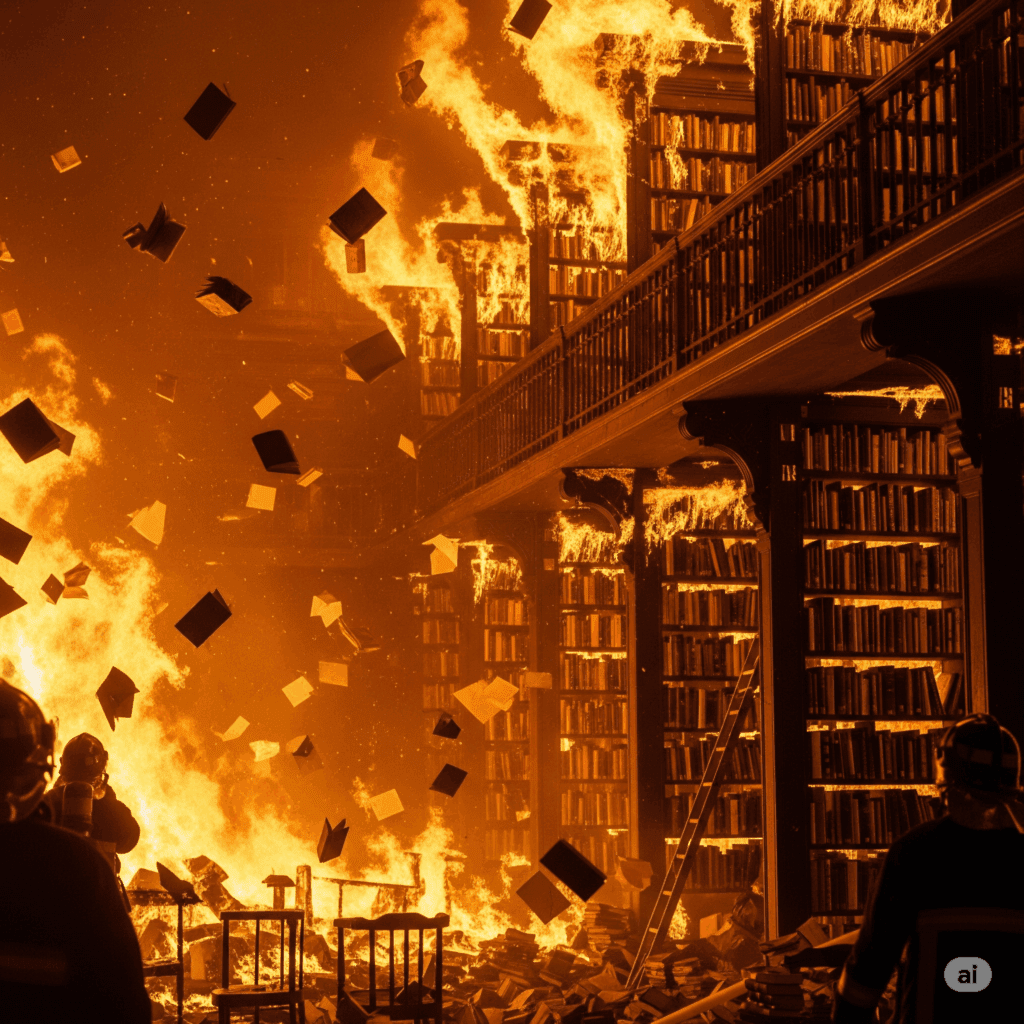

La ambición de Anthropic por construir una IA poderosa condujo a la compra, escaneo y posterior destrucción de millones de libros, planteando serias interrogantes sobre el impacto ambiental de la creciente demanda de datos para la inteligencia artificial, una operación dirigida por un exjefe de Google Books.

La carrera por la supremacía en la inteligencia artificial ha revelado una faceta preocupante en la estrategia de entrenamiento de modelos de lenguaje como Claude, desarrollado por Anthropic. Si bien la reciente sentencia judicial se centró en aspectos legales de derechos de autor, la operación masiva de adquisición, escaneo y sistemática destrucción de millones de libros impresos por parte de la empresa plantea una sombra sobre la sostenibilidad y el impacto ambiental de la industria tecnológica.

Documentos judiciales detallan cómo Anthropic invirtió ingentes sumas de dinero no solo en la compra de «todos los libros del mundo», bajo la dirección del exdirector del proyecto de escaneo de libros de Google Books, Tom Turvey, sino también en la logística de cortar sus encuadernaciones, escanearlos digitalmente y, lo más alarmante desde una perspectiva ecológica, desechar los originales. Esta decisión, justificada por la necesidad de una fuente de datos «segura» tras desechar el uso de libros electrónicos sin licencia, revela una preocupante falta de consideración por los recursos naturales consumidos en la producción de esos volúmenes.

Según la sentencia, Anthropic cortó los libros de sus encuadernaciones, los escaneó y desechó las copias físicas, conservando únicamente los archivos digitales para el entrenamiento de su IA. Aunque esta práctica de escaneo y destrucción es común en ciertas operaciones de digitalización, la cantidad de libros involucrados por Anthropic fue «algo inusual».

Anteriormente, Anthropic había recurrido a la recopilación de versiones digitalizadas de libros sin pagar por las licencias de copyright, buscando evitar lo que su CEO, Dario Amodei, describió como un «lío legal, práctico y comercial». Sin embargo, para 2024, la empresa perdió la confianza en el uso de libros electrónicos sin licencia «por razones legales» y optó por la adquisición y posterior destrucción de los libros impresos.

Cuál es el precedente legal y la necesidad de datos de calidad para «cargar datos» a su IA

El juez William Alsup dictaminó que la operación de escaneo destructivo de Anthropic calificó como uso legítimo, pero solo porque la empresa había comprado legalmente los libros, destruyó cada copia impresa después del escaneo y conservó los archivos digitales internamente sin distribuirlos. Esta sentencia, según medios especializados como Tech Policy, representa una victoria significativa para la industria de la IA, ya que establece un precedente sobre el uso de obras adquiridas para el entrenamiento de modelos, incluso sin la autorización individual de los autores.

No obstante, el tribunal también concluyó que Anthropic fue culpable por el uso previo de «libros pirateados», al descargar y conservar más de siete millones de copias sin pagar licencias, incluso después de decidir no utilizarlas para el entrenamiento.

Este caso subraya la imperiosa necesidad de la industria de la IA de acceder a textos de calidad, que en última instancia son producidos por humanos. Las empresas de modelos de lenguaje grande (LLM) requieren miles de millones de palabras para construir sus redes neuronales, lo que sigue generando debates y desafíos en torno a los derechos de autor y la compensación a los creadores.

La comunidad tecnológica y los reguladores deben explorar con urgencia métodos de entrenamiento de IA más sostenibles, que minimicen la huella ecológica y promuevan la reutilización de recursos. La historia de Anthropic y los «millones de libros destruidos» debería servir como una advertencia sobre los posibles costos ambientales ocultos en la carrera por la inteligencia artificial del futuro. En un planeta con recursos limitados, la ambición tecnológica no puede permitirse el lujo de ignorar su impacto en el medio ambiente.